LangChain vs LlamaIndex:業務アプリ開発での使い分けガイド【比較と事例付き】

目次

AI導入が進む中で、「ChatGPTを自社業務に活用したい」というニーズは急増しています。特に、エンタープライズ環境では、既存の業務フローと大規模言語モデル(LLM)をどう統合するかがカギになります。

本記事では、LLMアプリケーション構築で広く使われているLangChainと**LlamaIndex(旧GPT Index)**を比較しながら、両者の違いと業務への最適な活用法を解説します。

LangChainとは?何ができるのか?

LangChainは、LLMの機能を部品化して組み合わせ、柔軟なアプリケーションを作るためのライブラリです。複雑な処理フローも「チェーン」や「エージェント」という設計単位で整理できるため、構造的なLLMアプリの開発に向いています。

主な機能

- チェーン(Chain):複数のLLM処理をステップごとに組み立てる

- プロンプトテンプレート:動的プロンプトの作成

- メモリ機能:会話履歴の保持(チャットボットに必須)

- エージェント機能:外部ツール(計算、検索、API)と連携

- 多数のラッパー:OpenAI、Claude、Anthropicなどと連携可能

📌 こんな場面に最適

- ChatGPTのような会話アプリ

- 複数LLMの組み合わせ(例:要約→翻訳→メール生成)

- ノーコードでは表現しづらい業務ロジックの自動化

LlamaIndexとは?どんな時に使うのか?

LlamaIndexは、LLMと社内データの**“橋渡し”**をするライブラリです。大量の非構造データ(PDF、CSV、DB、APIなど)をベクトル化し、検索・問い合わせに適した形で提供します。

主な機能

- Data Connector:ローカルファイル、Notion、Google Driveなどの読み込み

- Index構築:ベクトルストア(FAISS, Chromaなど)との統合

- Retriever/Query Engine:自然言語クエリによる高速検索

- RAG構成の構築支援:LLMに必要な情報だけを動的に渡す設計が可能

📌 こんな場面に最適

- 社内文書(数千件以上)をLLMで検索したい

- PDFやマニュアルからFAQを自動生成

- LLMに「必要な情報だけ渡す」ことでコスト削減

機能比較表:LangChain vs LlamaIndex

| 項目 | LangChain | LlamaIndex |

|---|---|---|

| アプリ制御 | ◎ 複雑なワークフロー構築が得意 | △ 単体利用では弱い |

| 文書検索 | △ 外部ライブラリ依存 | ◎ 内部で高速検索が可能 |

| ツール連携 | ◎ エージェント経由でAPIや検索連携可 | △ 一部機能で可能 |

| メモリ管理 | ◎ 会話履歴の保持・再利用が可能 | △ 会話設計はLangChain側に委ねることが多い |

| RAG(検索強化生成) | ○ LangChainでも構成可能 | ◎ 得意領域 |

| 初学者向け | △ 設計が複雑な場合も多い | ◎ 単機能でシンプルに使いやすい |

実装例:コードで見る違い

LangChain:プロンプトチェーンを使った商品名生成

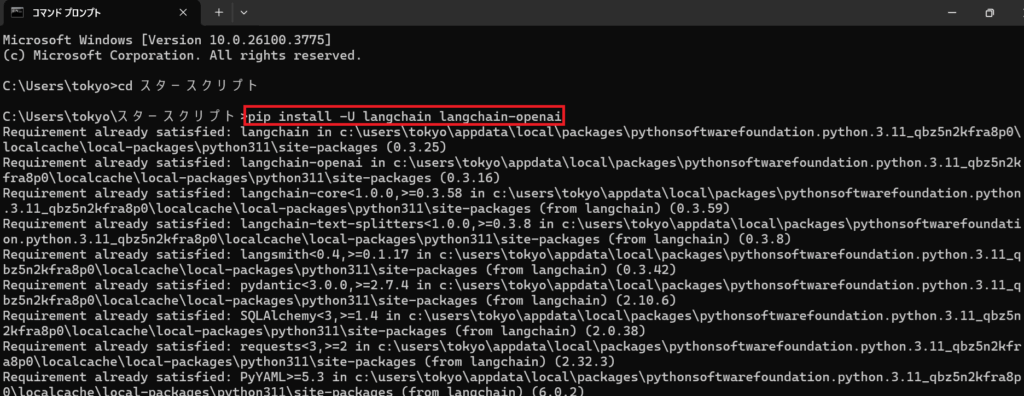

まず必要なライブラリ(最新版)をインストール:

pip install -U langchain langchain-openai

下記(ターミナル)のようにライブラリのインストールが開始されます

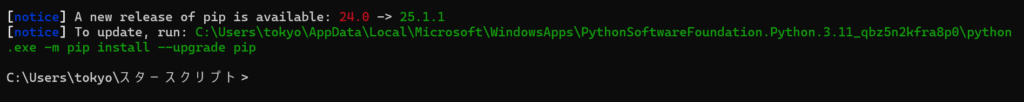

無事インストールが完了すると下記(ターミナル)のように表示されます

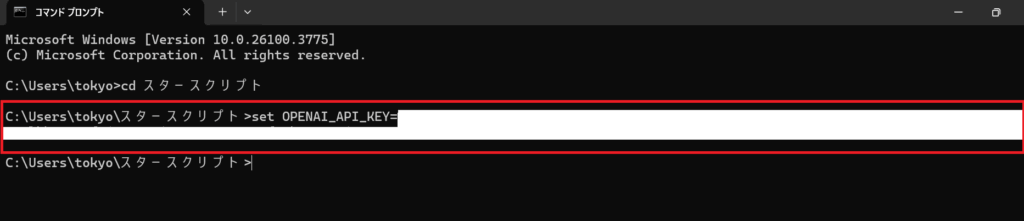

OpenAIのAPIキーが環境変数に設定されていること

- コマンドプロンプトやPowerShellで次を実行:

$env:OPENAI_API_KEY="sk-xxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxx"

下記のようにコマンドプロンプトで実行

(PowerShell(推奨)で設定する場合はこちら $env:OPENAI_API_KEY="sk-xxxxxxxxxxxxxx")

from langchain.prompts import PromptTemplate

from langchain.llms import OpenAI

from langchain.chains import LLMChain

prompt = PromptTemplate(

input_variables=["product"],

template="商品「{product}」に合うユニークな名前を考えてください。"

)

llm = OpenAI(temperature=0.7)

chain = LLMChain(llm=llm, prompt=prompt)

response = chain.run("AIベースの予定管理ツール")

print(response)

→ ユーザー入力 → プロンプトテンプレート → LLM出力、という直線的なフローが作れます。

LlamaIndex:PDF文書を読み込んで自然言語で質問

from llama_index import GPTVectorStoreIndex, SimpleDirectoryReader

documents = SimpleDirectoryReader('pdfs/').load_data()

index = GPTVectorStoreIndex.from_documents(documents)

query_engine = index.as_query_engine()

response = query_engine.query("このPDFの要点を教えてください。")

print(response)

→ 数十〜数百ページあるPDFから、必要情報だけを抽出して答えるRAG構成がすぐ作れます。

StarScriptとしての活用事例

弊社StarScriptでは、業務アプリケーション開発の中でLangChainとLlamaIndexを状況に応じて併用しています。

実際の活用例:

- 営業支援AIツール

- LlamaIndexで過去の提案資料やFAQをインデックス化

- LangChainでユーザー入力を理解し、適切な情報を抽出→Slack連携

- 社内ナレッジボット

- LlamaIndexでPDFやCSVから知識抽出

- LangChainで対話的なUI、メモリ、ユーザー管理を実装

このように、両者は競合ではなく補完関係にあります。

まとめ:どちらを選べばいい?

| あなたの目的 | 向いているツール |

|---|---|

| LLMを活用したプロダクトを構築したい | LangChain |

| 社内ドキュメントをLLMに読ませたい | LlamaIndex |

| 両方必要(文書検索+自動応答) | LangChain + LlamaIndex 併用 |

多くの業務では、「LlamaIndexで情報を整理し、LangChainで応答をデザインする」という分担がもっとも効率的です。

おわりに

LLM活用が本格化する今、単にAPIを呼ぶだけでなく、業務データとの統合やUX設計が重要になっています。LangChainとLlamaIndexを適切に使い分けることで、コスト効率・応答精度・ユーザー体験をすべて高めることが可能です。

合同会社StarScript(スター・スクリプト)では、こうした生成AIアプリのPoCから本番運用支援までワンストップでご相談いただけます。

AI導入に悩んでいる企業様は、ぜひ一度お問い合わせください。